Αναρωτηθήκατε ποτέ αν θα μπορούσατε να τρέξετε κάτι σαν το ChatGPT τοπικά στο Mac σας χωρίς να χρειάζεται το Διαδίκτυο; Με λίγη εγκατάσταση, μπορείτε πραγματικά. Και αυτό δωρεάν. Είτε θέλετε να διατηρήσετε τις συνομιλίες σας ιδιωτικές ή απλά θέλετε πρόσβαση εκτός σύνδεσης στο AI, εδώ μπορείτε να εκτελέσετε ισχυρά μεγάλα γλωσσικά μοντέλα τοπικά στο Mac σας.

#image_title

Πριν βυθίσουμε και ελέγξουμε τη ρύθμιση, εδώ είναι αυτό που θα χρειαστείτε:

Πώς να εκτελέσετε ένα LLM τοπικά σε Mac

Θα χρησιμοποιήσουμε ένα δωρεάν εργαλείο που ονομάζεταιΟλλάμα, που σας επιτρέπει να κατεβάσετε και να εκτελέσετε LLMS τοπικά με μερικές εντολές. Εδώ είναι πώς να ξεκινήσετε:

Βήμα 1: Εγκαταστήστε το homebrew (παραλείψτε εάν έχετε ήδη εγκατασταθεί)

Το Homebrew είναι ένας διαχειριστής πακέτων για macOS που σας βοηθά να εγκαταστήσετε εφαρμογές από την εφαρμογή Terminal. Εάν έχετε ήδη εγκαταστήσει το Homebrew στο Mac σας, μπορείτε να παραλείψετε αυτό το βήμα. Αλλά αν δεν το κάνετε, εδώ μπορείτε να το εγκαταστήσετε:

/bin/bash -c "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh)"brew doctor

Εάν βλέπετε "το σύστημά σας είναι έτοιμο να παρασκευάσει", είστε καλοί να πάτε.

Εάν έχετε προβλήματα ή θέλετε μια πιο λεπτομερή διαδικασία βήμα προς βήμα, ελέγξτε τον οδηγό μας για το πώς να εγκαταστήσετε το Homebrew σε Mac.

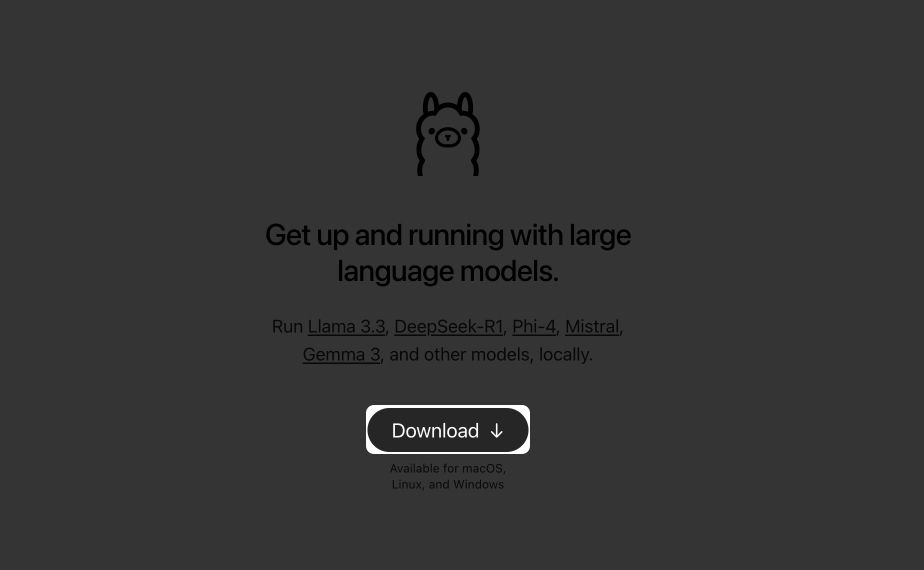

Βήμα 2: Εγκαταστήστε και εκτελέστε το Ollama

Τώρα που το Homebrew είναι εγκατεστημένο και έτοιμο για χρήση στο Mac σας, ας εγκαταστήσουμε το Ollama:

brew install ollamaollama serve

Αφήστε αυτό το παράθυρο να ανοίξει ή να το ελαχιστοποιήσει. Αυτή η εντολή διατηρεί το Ollama να τρέχει στο παρασκήνιο.

Εναλλακτικά, κατεβάστε τοΕφαρμογή Ollamaκαι να το εγκαταστήσετε όπως κάθε κανονική εφαρμογή MAC. Μόλις ολοκληρωθεί, ανοίξτε την εφαρμογή και συνεχίστε να τρέχετε στο παρασκήνιο.

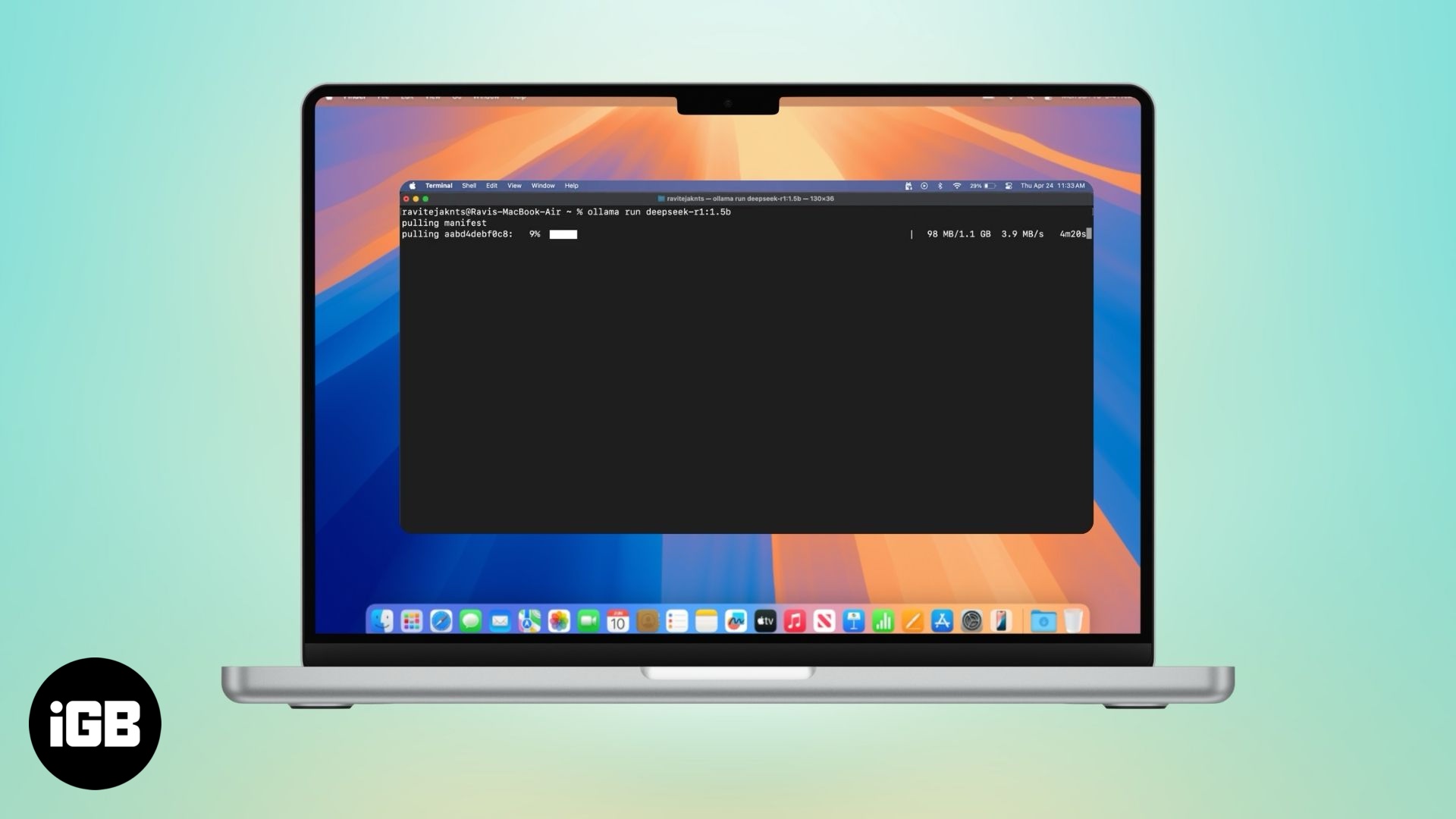

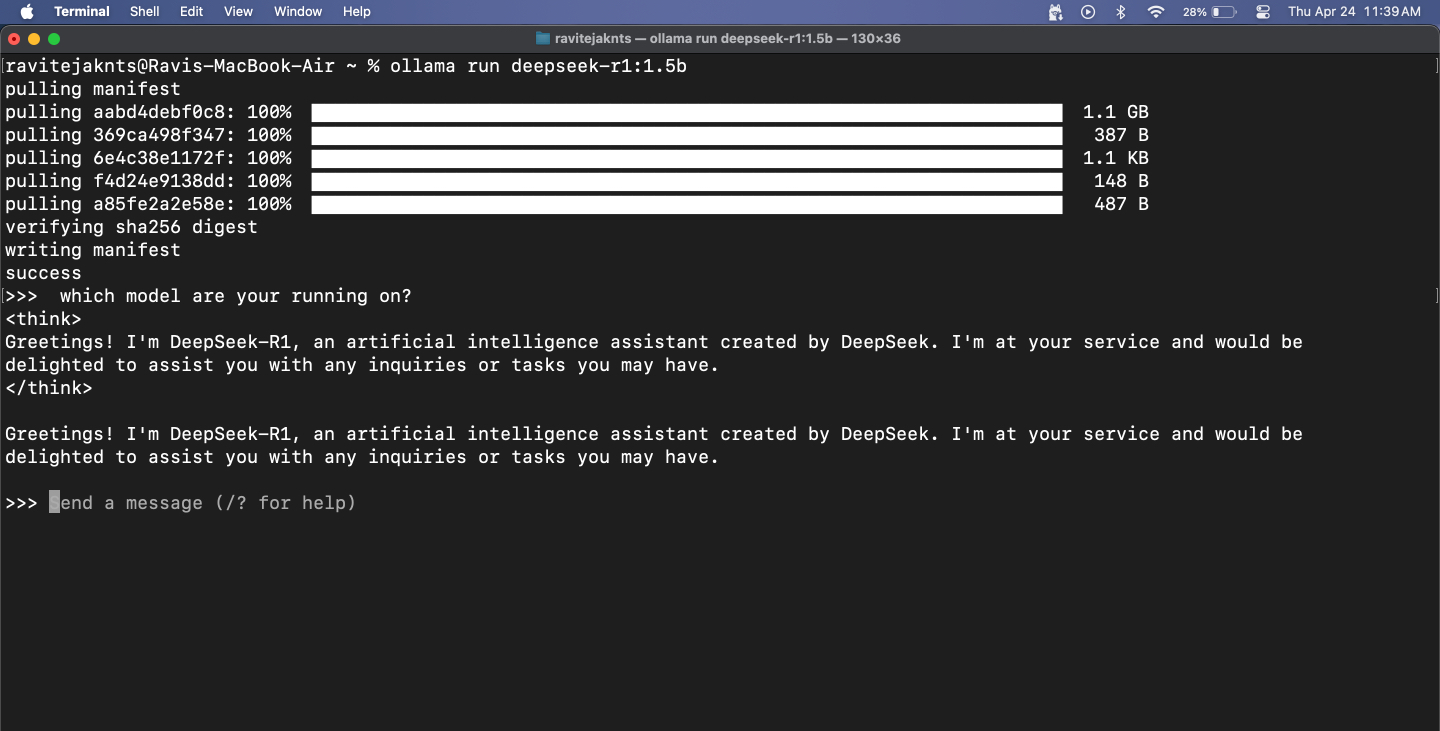

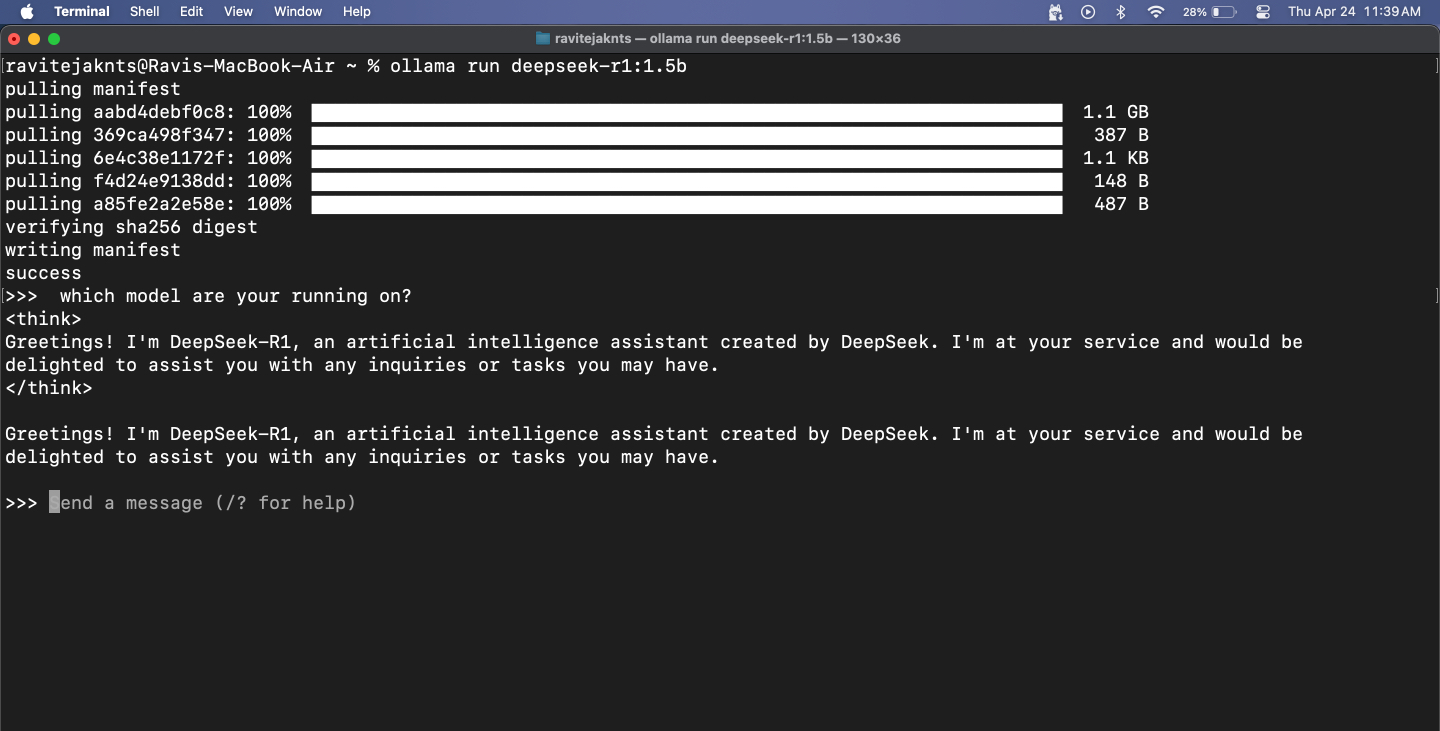

Βήμα 3: Κατεβάστε και εκτελέστε ένα μοντέλο

Το Ollama σας δίνει πρόσβαση σε δημοφιλή LLMS όπως το Deepseek, το Llama Meta, το Mistral, το Gemma και πολλά άλλα. Δείτε πώς μπορείτε να επιλέξετε και να εκτελέσετε ένα:

Εάν επιλέξετε ένα μεγάλο μοντέλο, περιμένετε κάποια καθυστέρηση - μετά από όλα, ολόκληρο το μοντέλο λειτουργεί τοπικά στο MacBook σας. Τα μικρότερα μοντέλα ανταποκρίνονται γρηγορότερα, αλλά μπορούν να αγωνιστούν με ακρίβεια, ειδικά για καθήκοντα μαθηματικών και λογικών. Επίσης, θυμηθείτε ότι, δεδομένου ότι αυτά τα μοντέλα δεν έχουν πρόσβαση στο διαδίκτυο, δεν μπορούν να λάβουν πληροφορίες σε πραγματικό χρόνο.

Τούτου λεχθέντος, για πράγματα όπως ο έλεγχος της γραμματικής, η γραφή μηνυμάτων ηλεκτρονικού ταχυδρομείου ή οι ιδέες του brainstorming, εργάζονται εξαιρετικά. Έχω χρησιμοποιήσει εκτενώς το Deepseek-R1 στο MacBook μου με μια ρύθμιση UI Web, η οποία μου επιτρέπει επίσης να ανεβάσω εικόνες και να επικολλήσω τα αποσπάσματα κώδικα. Ενώ οι απαντήσεις του-και ειδικά οι δεξιότητές του κωδικοποίησης-δεν είναι τόσο απότομες όσο τα μοντέλα κορυφαίων επιπέδων όπως το ChatGPT ή το Deepseek 671B, παίρνει ακόμα τα περισσότερα καθημερινά καθήκοντα που γίνονται χωρίς να χρειάζονται το Διαδίκτυο.

Βήμα 4: Συνομιλία με το μοντέλο στο Terminal

Μόλις εκτελεστεί το μοντέλο, μπορείτε απλά να πληκτρολογήσετε το μήνυμά σας και να χτυπήσετεΑπόδοση. Το μοντέλο θα ανταποκριθεί παρακάτω.

Για να βγείτε από τη συνεδρία, πατήστεΈλεγχος+dστο πληκτρολόγιό σας. Όταν θέλετε να ξεκινήσετε ξανά να συνομιλείτε, απλώς χρησιμοποιήστε το ίδιοollama run [model-name]εντολή. Δεδομένου ότι το μοντέλο έχει ήδη ληφθεί, θα ξεκινήσει αμέσως.

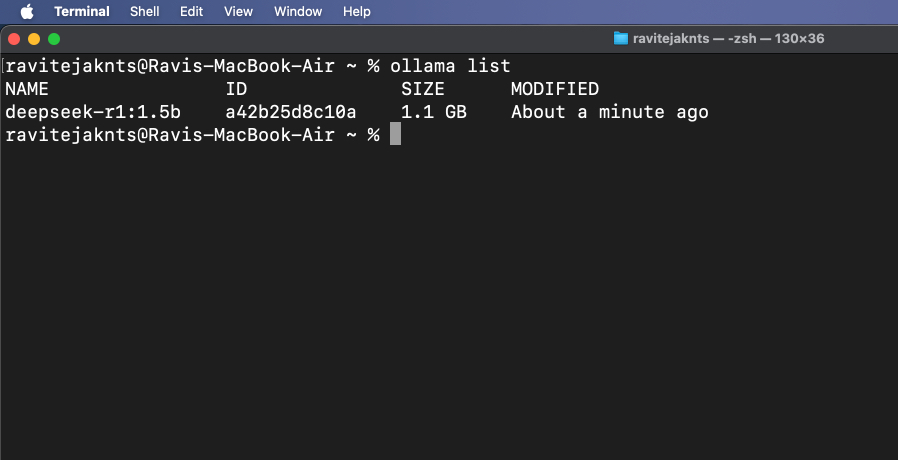

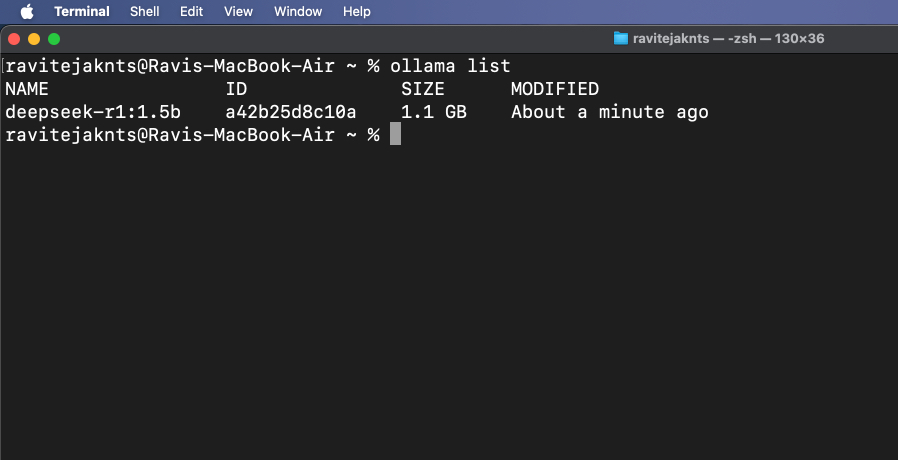

Βήμα 5: Προβολή και διαχείριση εγκατεστημένων μοντέλων

Για να ελέγξετε ποια μοντέλα κατεβάζονται επί του παρόντος, εκτελέστε:

ollama list

Για να διαγράψετε ένα μοντέλο που δεν χρειάζεστε πια, χρησιμοποιήστε:

ollama rm [model-name]Μπόνους: Χρησιμοποιήστε το Ollama με ένα UI στο διαδίκτυο

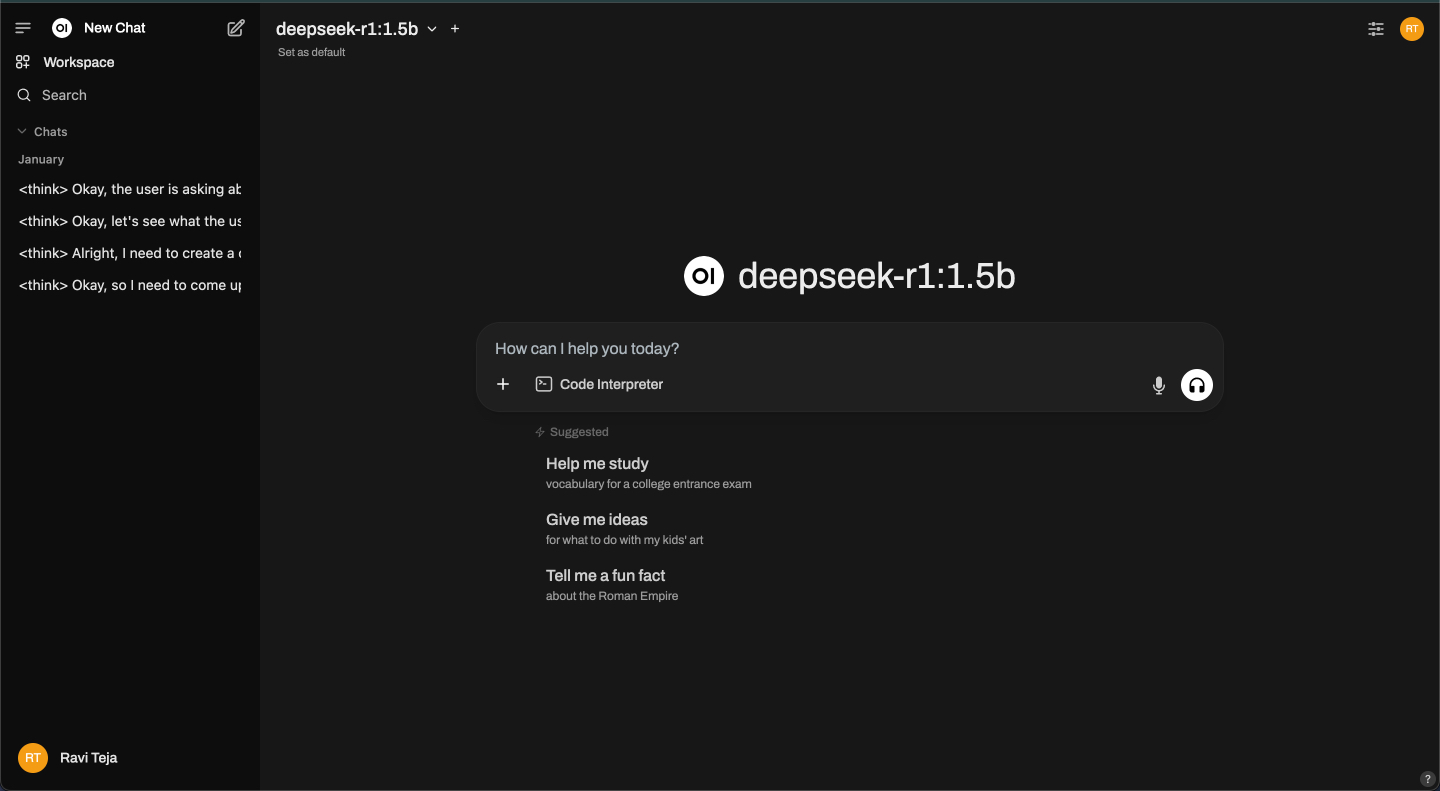

Ενώ το Ollama τρέχει στο τερματικό, ξεκινά επίσης μια τοπική υπηρεσία API στο https: // localhost: 11434, επιτρέποντάς σας να το συνδέσετε σε μια διεπαφή ιστού για οπτική αλληλεπίδραση με τα μοντέλα - παρόμοια με τη χρήση ενός chatbot. Μια δημοφιλής επιλογή για αυτό είναι το Open Webui, το οποίο παρέχει μια φιλική προς το χρήστη διεπαφή πάνω από τη βασική λειτουργικότητα του Ollama. Ας δούμε πώς να το ρυθμίσετε.

Βήμα 1: Εγκαταστήστε το Docker

Το Docker είναι ένα εργαλείο που σας επιτρέπει να συσκευάσετε ένα πρόγραμμα και όλα τα βασικά του στοιχεία σε ένα φορητό δοχείο, ώστε να μπορείτε να το εκτελέσετε εύκολα σε οποιαδήποτε συσκευή. Θα το χρησιμοποιήσουμε για να ανοίξουμε μια διαδικτυακή διεπαφή συνομιλίας για το μοντέλο AI.

Εάν το Mac σας δεν το έχει ήδη, ακολουθήστε αυτά τα βήματα για να εγκαταστήσετε το Docker:

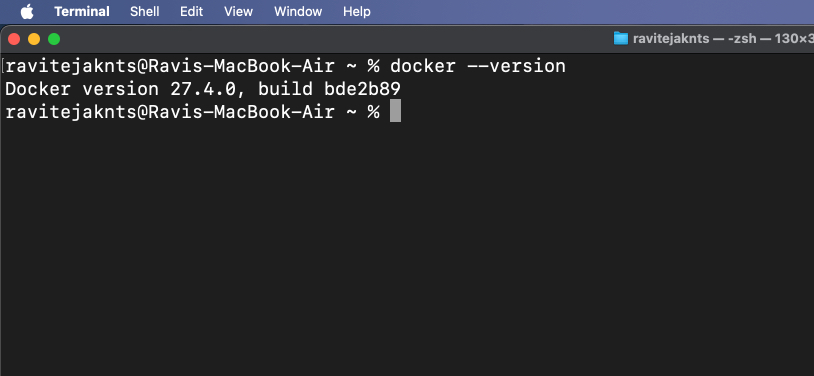

docker --version

Εάν η εντολή επιστρέψει έναν αριθμό έκδοσης, σημαίνει ότι το Docker είναι εγκατεστημένο στο Mac σας.

Βήμα 2: Τραβήξτε την ανοιχτή εικόνα webui

Το Open Webui είναι ένα απλό εργαλείο που σας δίνει ένα παράθυρο συνομιλίας στο πρόγραμμα περιήγησής σας. Το τράβηγμα της εικόνας σημαίνει απλώς τη λήψη των αρχείων που απαιτούνται για την εκτέλεση.

Για να το κάνετε αυτό, πηγαίνετε στοΤερματικόεφαρμογή και πληκτρολόγιο:

docker pull ghcr.io/open-webui/open-webui:mainΑυτό θα κατεβάσει τα απαραίτητα αρχεία για τη διεπαφή.

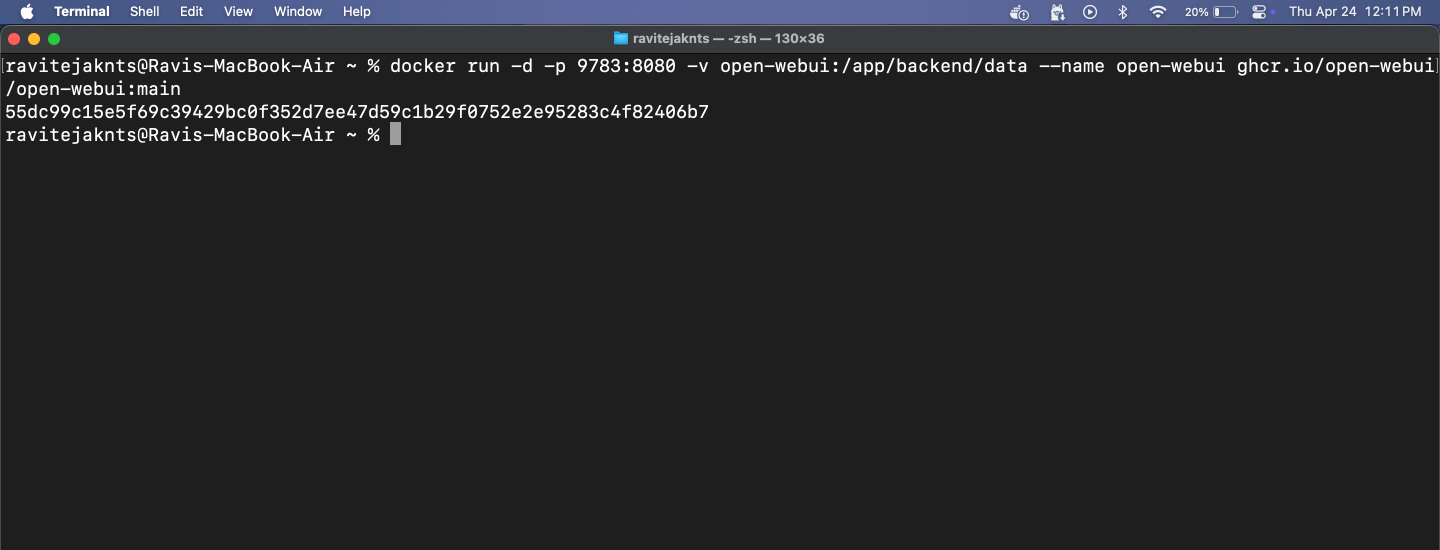

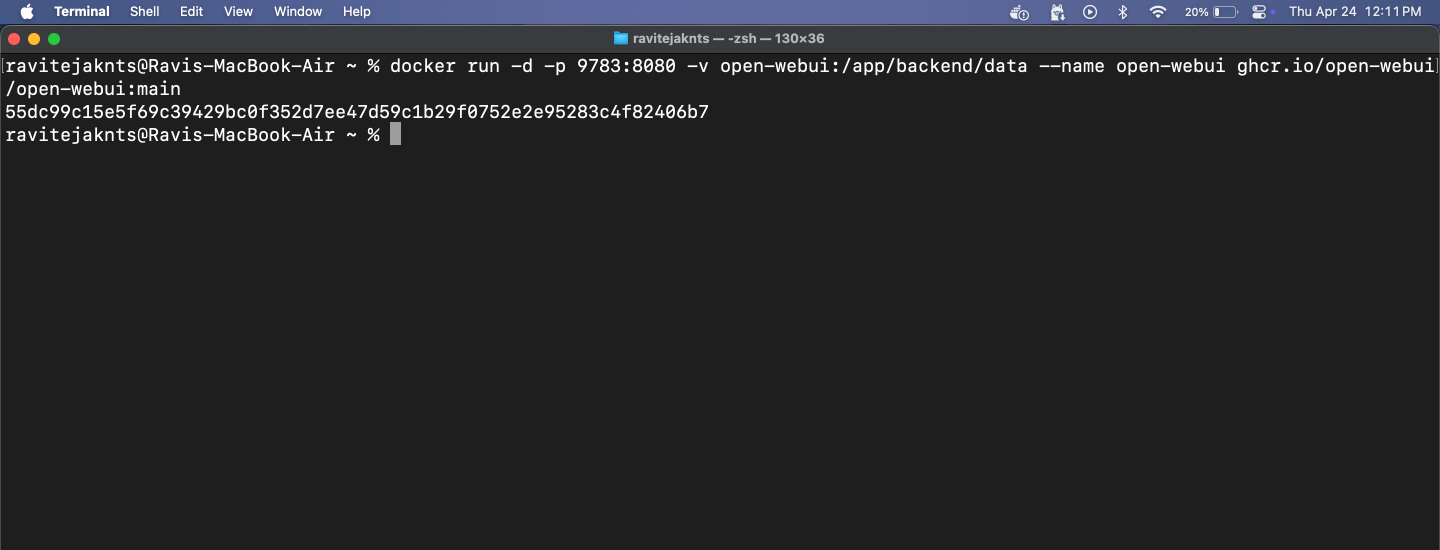

Βήμα 3: Εκτελέστε το δοχείο Docker και ανοίξτε το webui

Τώρα, ήρθε η ώρα να τρέξετε το ανοιχτό webui χρησιμοποιώντας το Docker. Θα δείτε μια καθαρή διεπαφή όπου μπορείτε να συνομιλήσετε με το AI -No Terminal που χρειάζεται. Εδώ πρέπει να κάνετε:

docker run -d -p 9783:8080 -v open-webui:/app/backend/data --name open-webui ghcr.io/open-webui/open-webui:main

https://localhost:9783/

ΣΥΓΓΕΝΕΥΩΝ:Πώς να εκτελέσετε τον Explorer File ως διαχειριστή στα Windows 11

Από εδώ, μπορείτε να συνομιλήσετε με οποιοδήποτε εγκατεστημένο μοντέλο σε μια καθαρή, φιλική προς το χρήστη διεπαφή προγράμματος περιήγησης. Αυτό το βήμα είναι προαιρετικό, αλλά σας δίνει μια ομαλότερη εμπειρία συνομιλίας χωρίς να χρησιμοποιήσετε το τερματικό.

Το Mac σας, το AI: Χωρίς διακομιστές, χωρίς χορδές

Αυτό είναι! Σε λίγα βήματα, έχετε ρυθμίσει το Mac σας για να εκτελέσετε ένα ισχυρό μοντέλο AI εντελώς εκτός σύνδεσης. Δεν υπάρχουν λογαριασμοί, κανένα σύννεφο και δεν χρειάζεται Διαδίκτυο μετά τη ρύθμιση. Είτε θέλετε ιδιωτικές συνομιλίες, τοπική παραγωγή κειμένου, ή απλά θέλετε να πειραματιστείτε με LLMS, το Ollama το καθιστά εύκολο και προσβάσιμο - ακόμη και αν δεν είστε προγραμματιστής. Δίνω μιά προσπάθεια!

Ελέγξτε επίσης αυτούς τους χρήσιμους οδηγούς: